|

Les outils de traitement du signal sont souvent utilisés dans le contexte stationnaire. Néanmoins, dans des domaines tels que la communication, le traitement de la parole, la mécanique, ... les hypothèses simplificatrices permettant de travailler dans un contexte stationnaire ne sont plus valables.

Pour illustrer cela, la figure ![]() montre un signal vibratoire issu d'un réducteur à engrenages. Nous pouvons noter la présence d'un motif d'allure périodique dans le signal. La période est indiquée par des rectangles alternativement noirs et blancs.

Cette périodicité apparente est due à l'existence d'un cycle de base que l'on rencontre dans la plupart des systèmes mécaniques et en particulier dans les machines tournantes. Si les paramètres de fonctionnement de la machine sont constants (vitesse moyenne, pression, température, durée du cycle moteur, période du réducteur) on dira que les signaux qui en sont issus sont cyclostationnaires. Mathématiquement, un signal est cyclostationnaire si l'on trouve des périodicités dans certaines de ses statistiques. Chaque période ou cycle peut être considéré comme la réalisation d'un même processus aléatoire.

Pour cela, chaque réalisation doit débuter à une position angulaire identique (même position de l'arbre pour un moteur électrique, même dents en contact pour les engrenages, ...). Si l'on superpose ces réalisations, on pourra alors calculer la moyenne d'ensemble (c'est-à-dire l'amplitude moyenne pour un angle

montre un signal vibratoire issu d'un réducteur à engrenages. Nous pouvons noter la présence d'un motif d'allure périodique dans le signal. La période est indiquée par des rectangles alternativement noirs et blancs.

Cette périodicité apparente est due à l'existence d'un cycle de base que l'on rencontre dans la plupart des systèmes mécaniques et en particulier dans les machines tournantes. Si les paramètres de fonctionnement de la machine sont constants (vitesse moyenne, pression, température, durée du cycle moteur, période du réducteur) on dira que les signaux qui en sont issus sont cyclostationnaires. Mathématiquement, un signal est cyclostationnaire si l'on trouve des périodicités dans certaines de ses statistiques. Chaque période ou cycle peut être considéré comme la réalisation d'un même processus aléatoire.

Pour cela, chaque réalisation doit débuter à une position angulaire identique (même position de l'arbre pour un moteur électrique, même dents en contact pour les engrenages, ...). Si l'on superpose ces réalisations, on pourra alors calculer la moyenne d'ensemble (c'est-à-dire l'amplitude moyenne pour un angle ![]() donné) comme le montre la figure

donné) comme le montre la figure ![]() . Cette moyenne d'ensemble, permettra d'extraire la ``partie périodique'' du signal (à l'ordre

. Cette moyenne d'ensemble, permettra d'extraire la ``partie périodique'' du signal (à l'ordre ![]() ). Lorsque cette dernière existe, le signal sera alors cyclostationnaire à l'ordre 1.

). Lorsque cette dernière existe, le signal sera alors cyclostationnaire à l'ordre 1.

Ce signal a été choisi car il permet de visualiser facilement ces périodicités. La partie périodique peut être noyée dans du bruit. Il faut alors utiliser la moyenne d'ensemble pour faire ressortir ce motif périodique par rapport au bruit (si ce bruit est stationnaire). En pratique, on ne disposera souvent que d'une seule réalisation et on sera conduit à remplacer la moyenne d'ensemble par une moyenne de cycles appelée moyenne synchrone (sous réserve d'existence).

Certains signaux de communication bien que non périodiques (à l'ordre 1), ont une énergie périodique. La figure ![]() inspirée de [#!max:methodes!#] présente un tel signal. Une fois élevé au carré, il devient périodique. On dira alors que ce signal présente des périodicités cachées. Un tel signal est cyclostationnaire à l'ordre 2. De façon plus générale, un signal est cyclostationnaire à l'ordre 2 si ses propriétés statistiques à l'ordre 2 sont périodiques.

inspirée de [#!max:methodes!#] présente un tel signal. Une fois élevé au carré, il devient périodique. On dira alors que ce signal présente des périodicités cachées. Un tel signal est cyclostationnaire à l'ordre 2. De façon plus générale, un signal est cyclostationnaire à l'ordre 2 si ses propriétés statistiques à l'ordre 2 sont périodiques.

La cyclostationnarité, cas particulier de la non-stationnarité nous permettra donc de mieux appréhender les périodicités cachées ou non d'un signal. Les machines tournantes générant intrinsèquement des périodicités, on aura intérêt à exploiter la cyclostationnarité.

Après avoir expliqué brièvement l'intérêt de la cyclostationnarité nous allons maintenant en présenter l'aspect théorique.

Les premières études sur la cyclostationnarité datent des années 1950 avec les travaux précurseurs de Benett [#!bennett:statistics!#] et Gladyshev [#!gladyshev:periodically1!#,#!gladyshev:periodically2!#]. Comme le montre la figure ![]() (issue de [#!gardner:cyclostationarity!#]) et la figure

(issue de [#!gardner:cyclostationarity!#]) et la figure ![]() , la cyclostationnarité a commencé à susciter un intérêt croissant à partir des années

, la cyclostationnarité a commencé à susciter un intérêt croissant à partir des années ![]() (explosion du domaine des télécommunications, ...). Elle a été utilisée dans l'identification, la séparation de sources, la séparation de signaux se recouvrant spectralement, ... Néanmoins, la cyclostationnarité n'a pas suscité le même engouement en mécanique : son utilisation dans ce domaine et en particulier pour les machines tournantes n'est apparue que récemment. Ce manque d'enthousiasme est probablement dû aux variations de vitesse des systèmes mécaniques qui ont tendance à supprimer la cyclostationnarité. D'autre part, il existe souvent une forte cyclostationnarité à l'ordre

(explosion du domaine des télécommunications, ...). Elle a été utilisée dans l'identification, la séparation de sources, la séparation de signaux se recouvrant spectralement, ... Néanmoins, la cyclostationnarité n'a pas suscité le même engouement en mécanique : son utilisation dans ce domaine et en particulier pour les machines tournantes n'est apparue que récemment. Ce manque d'enthousiasme est probablement dû aux variations de vitesse des systèmes mécaniques qui ont tendance à supprimer la cyclostationnarité. D'autre part, il existe souvent une forte cyclostationnarité à l'ordre ![]() qu'il est ardu de retrancher car sa période n'est pas forcément stable et connue. Il est alors difficile d'exploiter directement les outils développés dans le domaine des télécommunications où les signaux sont souvent à moyenne synchrone nulle. La cyclostationnarité a ouvert des perspectives et a permis d'obtenir des résultats très intéressants [#!lejeune:cyclostationnarites!#,#!mccormick:cyclostationarity!#,#!dalpiaz:effectiveness!#,#!capdessus:aide!#,#!capdessus:cyclostationary!#,#!randall:relationship!#,#!bouillaut:cyclostationary!#,#!antoni:effective1!#,#!antoni:cyclostationary!#,#!raad:contributions!#].

qu'il est ardu de retrancher car sa période n'est pas forcément stable et connue. Il est alors difficile d'exploiter directement les outils développés dans le domaine des télécommunications où les signaux sont souvent à moyenne synchrone nulle. La cyclostationnarité a ouvert des perspectives et a permis d'obtenir des résultats très intéressants [#!lejeune:cyclostationnarites!#,#!mccormick:cyclostationarity!#,#!dalpiaz:effectiveness!#,#!capdessus:aide!#,#!capdessus:cyclostationary!#,#!randall:relationship!#,#!bouillaut:cyclostationary!#,#!antoni:effective1!#,#!antoni:cyclostationary!#,#!raad:contributions!#].

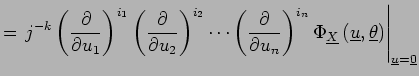

Tout comme pour la stationnarité, nous allons définir la cyclostationnarité à l'ordre ![]() . Pour cela nous devons tout d'abord rappeler la définition des moments et cumulants dans le contexte cyclostationnaire.

. Pour cela nous devons tout d'abord rappeler la définition des moments et cumulants dans le contexte cyclostationnaire.

Puisque nous nous interéssons plus particulièrement aux machines tournantes, nous allons utiliser leur variable générique : l'angle ![]() au lieu du temps

au lieu du temps ![]() . Pour plus de simplicité, nous nous limiterons aux vecteurs aléatoires réels. Le cas des vecteurs aléatoires complexes est traité notamment dans [#!lacoume:statistiques!#,#!amblard:statistics!#].

. Pour plus de simplicité, nous nous limiterons aux vecteurs aléatoires réels. Le cas des vecteurs aléatoires complexes est traité notamment dans [#!lacoume:statistiques!#,#!amblard:statistics!#].

Soit un vecteur aléatoire

![]() de dimension

de dimension ![]() à valeurs réelles admettant comme fonction de répartition

à valeurs réelles admettant comme fonction de répartition

![]() (avec

(avec

![]() et

et

![]() ) définie par :

) définie par :

| (1.1) |

Il est important de noter que nous travaillons pour l'instant sur des réalisations de ![]() et que nous n'avons fait aucune hypothèse quant à l'ergodicité.

A partir de ce vecteur aléatoire, il est alors possible de définir la fonction caractéristique qui n'est autre que la transformée de Fourier de la densité de probabilité (à

et que nous n'avons fait aucune hypothèse quant à l'ergodicité.

A partir de ce vecteur aléatoire, il est alors possible de définir la fonction caractéristique qui n'est autre que la transformée de Fourier de la densité de probabilité (à ![]() près).

près).

|

(1.2) | ||

|

(1.3) |

Où

![]() désigne la différentielle de la fonction de répartition. Ici nous utilisons la fonction de répartition plutôt que la densité de probabilité. En effet, à une fonction de répartition pourra correspondre une distribution de densité de probabilité (par exemple si la fonction de répartition est un échelon). Cette fonction de répartition peut être décomposée en une somme de deux termes et écrite sous la forme :

désigne la différentielle de la fonction de répartition. Ici nous utilisons la fonction de répartition plutôt que la densité de probabilité. En effet, à une fonction de répartition pourra correspondre une distribution de densité de probabilité (par exemple si la fonction de répartition est un échelon). Cette fonction de répartition peut être décomposée en une somme de deux termes et écrite sous la forme :

| (1.4) |

![]() étant la partie continue et dérivable, et,

étant la partie continue et dérivable, et,

![]() une fonction de type escalier. La première fonction caractéristique correspondra à une variable aléatoire continue, la deuxième à une variable aléatoire discrète. Ainsi, cette formulation permettra de traiter à la fois le cas discret et le cas continu.

une fonction de type escalier. La première fonction caractéristique correspondra à une variable aléatoire continue, la deuxième à une variable aléatoire discrète. Ainsi, cette formulation permettra de traiter à la fois le cas discret et le cas continu.

On définit également la seconde fonction caractéristique par:

| (1.5) |

Il est alors possible de développer les fonctions caractéristiques en série entière. Les coefficients de ces séries permettront alors de retrouver les moments pour

![]() et les cumulants pour

et les cumulants pour

![]() .

.

Pour tout n-uplet

![]() tel que

tel que

![]() , le moment d'ordre

, le moment d'ordre ![]() est défini par:

est défini par:

|

(1.6) |

On pourra retrouver également les moments à partir de la fonction caractéristique:

|

(1.7) | ||

|

|

(1.8) |

Comme on se place dans le cas de vecteurs aléatoires, choisir un ![]() équivaut à utiliser un vecteur aléatoire contenant plusieurs fois la même variable aléatoire. On se limitera donc à

équivaut à utiliser un vecteur aléatoire contenant plusieurs fois la même variable aléatoire. On se limitera donc à ![]() et

et ![]()

![]() . On pourra alors définir la notation :

. On pourra alors définir la notation :

|

(1.9) |

Par exemple, la variance sera interprétée comme la covariance de deux vecteurs identiques et pourra être notée

![]() .

.

Dans le cas d'un vecteur aléatoire, l'ordre

![]() pourra être omis pour

pourra être omis pour ![]() .

.

En utilisant exactement la même procédure mais à partir de la seconde fonction caractéristique, nous obtenons les cumulants. Pour les mêmes raisons, nous choisirons d'utiliser les cumulants simples c'est-à-dire avec ![]()

![]() . Nous aurons alors :

. Nous aurons alors :

|

(1.10) |

Il est important de noter que nous utilisons

![]() et non

et non

![]() puisque nous ne nous plaçons pas dans le contexte stationnaire. Pour un signal unidimensionnel, nous avons

puisque nous ne nous plaçons pas dans le contexte stationnaire. Pour un signal unidimensionnel, nous avons

![]() où

où ![]() est un vecteur contenant

est un vecteur contenant ![]() fois la variable aléatoire

fois la variable aléatoire ![]() :

:

![$\vect{Y}=\underbrace{\left[X,\cdots,X\right]}_{k fois}$](img115.png) .

.

Il est possible d'exprimer les cumulants d'ordre ![]() en fonction des moments à l'aide de la formule de Leonov et Shiryaev [#!leonov:method!#] en utilisant les

en fonction des moments à l'aide de la formule de Leonov et Shiryaev [#!leonov:method!#] en utilisant les ![]() partitions

partitions

![]() de l'ensemble

de l'ensemble

![]() :

:

|

(1.11) |

Par exemple, à l'ordre 2, on a

![]() et

et

![]() d'où :

d'où :

| (1.12) |

On a également :

| (1.13) |

Ces formules se simplifient en utilisant des signaux centrés1.1 pour lesquels

![]() . Jusqu'à l'ordre

. Jusqu'à l'ordre ![]() , le cumulant correspond au moment calculé sur le signal centré. Le contexte cyclostationnaire nous empêche de simplifier plus ces formules puisque

, le cumulant correspond au moment calculé sur le signal centré. Le contexte cyclostationnaire nous empêche de simplifier plus ces formules puisque

![]() .

.

Cette formule montre que les cumulants d'ordre ![]() dépendent uniquement des moments d'ordre inférieur.

dépendent uniquement des moments d'ordre inférieur.

Il est également possible d'exprimer les moments à partir des cumulants :

On peut en déduire :

| (1.15) | |||

| (1.16) |

Tout comme les cumulants, les moments d'ordre ![]() ne sont liés qu'aux cumulants d'ordre inférieur. Après avoir défini les moments et cumulants, nous allons les utiliser afin de caractériser les différents types de cyclostationnarité.

ne sont liés qu'aux cumulants d'ordre inférieur. Après avoir défini les moments et cumulants, nous allons les utiliser afin de caractériser les différents types de cyclostationnarité.

L'utilisation des cumulants permet d'estimer des statistiques qui rendent compte des propriètés à l'ordre ![]() seul, alors que les statistiques issues des moments prennent en compte tous les ordres de

seul, alors que les statistiques issues des moments prennent en compte tous les ordres de ![]() à

à ![]() .

.

Par exemple, à l'ordre ![]() , pour une variable aléatoire

, pour une variable aléatoire

![]() , de moyenne

, de moyenne

![]() qui peut s'écrire :

qui peut s'écrire :

| (1.17) |

Le cumulant d'ordre ![]() est :

est :

et le moment d'ordre 2 :

L'équation (![]() ) montre que le cumulant ne dépend pas de la statistique d'ordre

) montre que le cumulant ne dépend pas de la statistique d'ordre ![]() contrairement au moment d'ordre 2 pour lequel la contribution à l'ordre

contrairement au moment d'ordre 2 pour lequel la contribution à l'ordre ![]() est ajoutée (équation

est ajoutée (équation ![]() ). Le cumulant à l'ordre

). Le cumulant à l'ordre ![]() retranche donc la contribution issue de l'ordre

retranche donc la contribution issue de l'ordre ![]() et permet ainsi de se focaliser sur l'ordre

et permet ainsi de se focaliser sur l'ordre ![]() .

.

Soit

![]() un processus stochastique complexe ou réel.

un processus stochastique complexe ou réel.

![]() est dit cyclostationnaire au sens strict avec la période cyclique

est dit cyclostationnaire au sens strict avec la période cyclique ![]() si sa fonction de répartition est périodique avec la période

si sa fonction de répartition est périodique avec la période ![]() :

:

Que l'on peut écrire de manière plus compacte :

La définition de la stationnarité au sens strict peut être retrouvée à partir de cette définition, en supprimant la notion de périodicité. Un processus stochastique

![]() complexe ou réel est dit stationnaire au sens strict si sa fonction de répartition est invariante pour tout changement de l'origine du temps :

complexe ou réel est dit stationnaire au sens strict si sa fonction de répartition est invariante pour tout changement de l'origine du temps :

| (1.22) |

Dès lors, comme tout signal stationnaire vérifie forcément (![]() ), la classe des signaux stationnaires est incluse dans la classe des signaux cyclostationnaires et hérite donc de toutes ses propriétés.

), la classe des signaux stationnaires est incluse dans la classe des signaux cyclostationnaires et hérite donc de toutes ses propriétés.

![]() est dit cyclostationnaire à l'ordre n (

est dit cyclostationnaire à l'ordre n (![]() ) avec une période cyclique

) avec une période cyclique ![]() si son moment d'ordre

si son moment d'ordre ![]() existe, et est périodique de période

existe, et est périodique de période

![]() :

:

![]() est dit cyclostationnaire au sens large, s'il est cyclostationnaire conjointement à l'ordre

est dit cyclostationnaire au sens large, s'il est cyclostationnaire conjointement à l'ordre ![]() et à l'ordre

et à l'ordre ![]() .

.

La définition de la stationnarité au sens large peut être retrouvée à partir de cette définition en supprimant la notion de périodicité :

![]() est dit stationnaire au sens large s'il est stationnaire à l'ordre

est dit stationnaire au sens large s'il est stationnaire à l'ordre ![]() et stationnaire à l'ordre

et stationnaire à l'ordre ![]() .

.

Soit un signal déterministe

![]() sinusoïdal :

sinusoïdal :

![]() . Ce signal est cyclostationnaire à l'ordre

. Ce signal est cyclostationnaire à l'ordre ![]() car il est périodique. Son moment d'ordre

car il est périodique. Son moment d'ordre ![]() est :

est :

| (1.24) | |||

| (1.25) |

Dans cet exemple très simple, le moment d'ordre ![]() est lié au moment d'ordre inférieur par

est lié au moment d'ordre inférieur par

![]() . On a donc affaire à un signal cyclostationnaire à tous les ordres. On ne pourra donc pas étudier séparément l'apport de chaque ordre. On parlera alors de cyclostationnarité ``impure'' puisque

. On a donc affaire à un signal cyclostationnaire à tous les ordres. On ne pourra donc pas étudier séparément l'apport de chaque ordre. On parlera alors de cyclostationnarité ``impure'' puisque ![]() est une conséquence de

est une conséquence de ![]() .

.

A l'ordre ![]() , il est possible en travaillant sur le signal centré (c'est-à-dire le cumulant) de supprimer l'influence de l'ordre

, il est possible en travaillant sur le signal centré (c'est-à-dire le cumulant) de supprimer l'influence de l'ordre ![]() . Par exemple, pour un signal

. Par exemple, pour un signal

![]() composé d'un signal

composé d'un signal

![]() cyclostationnaire à l'ordre

cyclostationnaire à l'ordre ![]() et d'un autre signal quelconque et indépendant de

et d'un autre signal quelconque et indépendant de

![]() , le cumulant d'ordre

, le cumulant d'ordre ![]() ne dépendra pas de

ne dépendra pas de

![]() contrairement au moment.

contrairement au moment.

| (1.26) | |||

| (1.27) |

L'utilisation des cumulants au lieu des moments pourra alors être généralisée aux ordres supérieurs [#!gardner:cumulant!#]. On parlera alors de cyclostationnarité ``pure'' à l'ordre ![]() (noté

(noté ![]() ) puisqu'elle n'entrainera pas

) puisqu'elle n'entrainera pas ![]() . On pourra alors caractériser la cyclostationnarité pour un ordre donné indépendamment des autres ordres.

. On pourra alors caractériser la cyclostationnarité pour un ordre donné indépendamment des autres ordres.

A l'aide de l'équation ![]() , il est possible d'établir les implications entre

, il est possible d'établir les implications entre ![]() et

et ![]() .

.

| Cyclostationnarité impure à l'ordre ... | ... si |

| 2 | |

| 3 | |

| 4 |

Afin de montrer l'apport des cumulants, nous allons examiner un signal

![]() issu d'un moteur diesel 4 cylindres PSA XUD9

issu d'un moteur diesel 4 cylindres PSA XUD9 ![]() . Il a été acquis sous échantillonnage angulaire et exploité dans [#!antoni:apports!#,#!antoni:effective1!#,#!antoni:cyclostationary!#]. Ce signal est cyclostationnaire puisque chaque événement mécanique est lié à la position du vilebrequin.

Ce signal peut être décomposé en [#!braun:analysis!#]:

. Il a été acquis sous échantillonnage angulaire et exploité dans [#!antoni:apports!#,#!antoni:effective1!#,#!antoni:cyclostationary!#]. Ce signal est cyclostationnaire puisque chaque événement mécanique est lié à la position du vilebrequin.

Ce signal peut être décomposé en [#!braun:analysis!#]:

| (1.28) |

Les figures ![]() à

à ![]() montrent l'apport des cumulants pour caractériser le signal à l'ordre

montrent l'apport des cumulants pour caractériser le signal à l'ordre ![]() . Le signal analysé ainsi que sa densité spectrale de puissance ont été ajoutés sur les bordures des figures. Parmi les

. Le signal analysé ainsi que sa densité spectrale de puissance ont été ajoutés sur les bordures des figures. Parmi les ![]() caractérisations possibles du signal, nous avons choisi la distribution de Wigner-Ville car c'est la transformée de Fourier d'un moment d'ordre

caractérisations possibles du signal, nous avons choisi la distribution de Wigner-Ville car c'est la transformée de Fourier d'un moment d'ordre ![]() . Ce domaine permet de localiser facilement les événements mécaniques. Les figures

. Ce domaine permet de localiser facilement les événements mécaniques. Les figures ![]() ,

, ![]() ,

, ![]() montrent respectivement la distribution de Wigner-Ville associée au moment d'ordre 2 (corrélation), à la moyenne synchrone, et au cumulant d'ordre 2 (variance - on parle alors de spectre de Wigner Ville). L'amplitude des signaux a été normalisée avant les traitements car les calibres utilisés dans la chaîne de mesure n'étaient pas disponibles. Ainsi, nous utilisons

montrent respectivement la distribution de Wigner-Ville associée au moment d'ordre 2 (corrélation), à la moyenne synchrone, et au cumulant d'ordre 2 (variance - on parle alors de spectre de Wigner Ville). L'amplitude des signaux a été normalisée avant les traitements car les calibres utilisés dans la chaîne de mesure n'étaient pas disponibles. Ainsi, nous utilisons

![]() pour indiquer que l'échelle est homogène à des

pour indiquer que l'échelle est homogène à des ![]() .

.

Les figures ![]() et

et ![]() mettent en évidence que la composante périodique ou

mettent en évidence que la composante périodique ou ![]() du signal est beaucoup plus énergétique que la composante

du signal est beaucoup plus énergétique que la composante ![]() . En conséquence, cette composante domine et provoque des interférences dûes à son caractère déterministe qui nuisent à la lisibilité. Dans la figure

. En conséquence, cette composante domine et provoque des interférences dûes à son caractère déterministe qui nuisent à la lisibilité. Dans la figure ![]() , il n'y a que la composante

, il n'y a que la composante ![]() exempte de toutes interférence détruite par moyennage synchrone de la contribution à l'ordre

exempte de toutes interférence détruite par moyennage synchrone de la contribution à l'ordre ![]() . L'étude de ces signaux dans [#!antoni:apports!#] a montré l'intérêt de la partie

. L'étude de ces signaux dans [#!antoni:apports!#] a montré l'intérêt de la partie ![]() pour le diagnostic et la localisation des défauts. Il est donc très important et intéressant dans ce cas d'étudier séparément la partie

pour le diagnostic et la localisation des défauts. Il est donc très important et intéressant dans ce cas d'étudier séparément la partie ![]() et la partie

et la partie ![]() .

.

Cet exemple montre que l'utilisation des cumulants permet d'analyser la contribution de chaque ordre sans être gêné par l'ordre précédent. Jusqu'à l'ordre ![]() , l'estimation des cumulants est en théorie assez simple puisqu'il suffit de travailler sur des signaux centrés (débarrassés de leur moyenne synchrone). Nous verrons au cours de cette thèse, qu'en pratique, il n'est pas toujours simple d'enlever cette moyenne (synchrone).

, l'estimation des cumulants est en théorie assez simple puisqu'il suffit de travailler sur des signaux centrés (débarrassés de leur moyenne synchrone). Nous verrons au cours de cette thèse, qu'en pratique, il n'est pas toujours simple d'enlever cette moyenne (synchrone).

La cyclostationnarité est très intéressante pour étudier les machines tournantes puisqu'elle permet de prendre en compte le caractère cyclique d'un processus. Jusque là nous avons supposé une seule période cyclique. Or, il existe des processus ou des machines qui possèdent plusieurs cycles. Nous allons alors étendre la notion de cyclostationnarité afin de l'adapter à de tels cas.

La presque cyclostationnarité (almost cyclostationary en anglais) [#!gardner:stationarizable!#] est basée sur les fonctions presque périodiques (ou p-périodiques). De telles fonctions sont étudiées dans [#!bass:mathematiques!#,#!corduneanu:almost!#].

Une fonction

![]() est dite p-périodique sur

est dite p-périodique sur ![]() si, pour tout réel

si, pour tout réel ![]() , il existe un polynôme trigonométrique

, il existe un polynôme trigonométrique

![]() (

(

![]() ) tel que :

) tel que :

Où ![]() est un ensemble de fréquences qui ne sont pas forcément harmoniques entre elles.

est un ensemble de fréquences qui ne sont pas forcément harmoniques entre elles.

On notera alors :

| (1.30) |

Si la série de Fourier Bohr est uniformément convergente, alors, on peut écrire :

| (1.31) |

Dans [#!corduneanu:almost!#], il est montré que la définition (![]() ) implique que :

) implique que :

Pour tout réel ![]() , il existe un nombre

, il existe un nombre

![]() tel que tout intervalle de longueur

tel que tout intervalle de longueur

![]() contienne un nombre

contienne un nombre ![]() vérifiant :

vérifiant :

| (1.32) |

Cette formulation utilisée dans [#!lacoume:statistiques!#] montre mieux l'aspect ``périodique'' avec l'utilisation de ![]() . Il est possible de construire une fonction presque périodique en ajoutant

. Il est possible de construire une fonction presque périodique en ajoutant ![]() fonctions périodiques

fonctions périodiques

![]() ayant des périodes

ayant des périodes ![]() non commensurables entre elles1.2. Chacune des fonctions périodiques

non commensurables entre elles1.2. Chacune des fonctions périodiques

![]() admet alors une décomposition en série de Fourier :

admet alors une décomposition en série de Fourier :

|

(1.33) |

Où ![]() est le coefficient associé à la fréquence

est le coefficient associé à la fréquence ![]() de la

de la

![]() fonction

fonction

![]() de période

de période ![]() . Dès lors, on pourra combiner les séries de Fourier associées à chaque fonction :

. Dès lors, on pourra combiner les séries de Fourier associées à chaque fonction :

|

(1.34) |

Où ![]() est le coefficient associé à la fréquence

est le coefficient associé à la fréquence ![]() . Chaque fréquence

. Chaque fréquence ![]() correspond alors à une unique fréquence

correspond alors à une unique fréquence ![]() . On décompose alors la fonction

. On décompose alors la fonction

![]() sous forme d'une série. Néanmoins, comme les périodes

sous forme d'une série. Néanmoins, comme les périodes ![]() sont incommensurables entre elles (dans notre exemple), les fréquences

sont incommensurables entre elles (dans notre exemple), les fréquences ![]() , rangées par ordre croissant, ne sont pas en progression linéaire. Il ne s'agit donc plus d'une série de Fourier puisque les

, rangées par ordre croissant, ne sont pas en progression linéaire. Il ne s'agit donc plus d'une série de Fourier puisque les ![]() ne sont pas les harmoniques d'un même fondamental mais d'une décomposition en série de Fourier-Bohr. La fonction

ne sont pas les harmoniques d'un même fondamental mais d'une décomposition en série de Fourier-Bohr. La fonction

![]() est alors une fonction presque périodique. D'autre part, on ne peut plus écrire

est alors une fonction presque périodique. D'autre part, on ne peut plus écrire

![]() puisqu'il n'existe aucune période commune entre les

puisqu'il n'existe aucune période commune entre les ![]() , les fonctions presque-périodiques permettent ainsi de décrire les fonctions comportant plusieurs périodes sans période commune.

, les fonctions presque-périodiques permettent ainsi de décrire les fonctions comportant plusieurs périodes sans période commune.

Un processus stochastique

![]() réel est dit presque cyclostationnaire au sens strict si sa fonction de répartition est presque périodique.

réel est dit presque cyclostationnaire au sens strict si sa fonction de répartition est presque périodique.

Il sera alors possible de décliner la presque cyclostationnarité à différents ordres en remplaçant périodique par presque périodique. Ainsi, la presque cyclostationnarité au sens large est définie dans [#!gardner:stationarizable!#] par :

Un processus aléatoire centré du second ordre à paramètres réels et continus est presque-cyclostationnaire au sens large si et seulement si, pour tout ![]() , il existe un nombre entier naturel

, il existe un nombre entier naturel ![]() et un polynôme trigonométrique à l'ordre

et un polynôme trigonométrique à l'ordre ![]() dans

dans

![]() qui approxime uniformément la fonction d'autocorrélation pour X à

qui approxime uniformément la fonction d'autocorrélation pour X à

![]() , c'est-à-dire :

, c'est-à-dire :

|

(1.35) |

On a ainsi une autocorrélation

![]() presque périodique.

presque périodique.

Alors que dans le contexte cyclostationnaire nous avions une période, nous avons ici un ensemble de presque périodes ![]() qui peuvent être quelconques. On peut alors en mettant des contraintes sur ces presque périodes faire apparaître des sous-ensembles des signaux presque cyclostationnaires.

qui peuvent être quelconques. On peut alors en mettant des contraintes sur ces presque périodes faire apparaître des sous-ensembles des signaux presque cyclostationnaires.

Parmi les fonctions presques périodiques, les fonctions polypériodiques vont nous permettre de construire un sous-ensemble des processus presque cyclostationnaires : les processus polycyclostationnaires. Nous allons tout d'abord définir la polypériodicité :

Une fonction

![]() est dite polypériodique avec les fréquences fondamentales associées

est dite polypériodique avec les fréquences fondamentales associées

![]() si elle est presque périodique, et si les fréquences associées aux coefficients de Fourier-Bohr

si elle est presque périodique, et si les fréquences associées aux coefficients de Fourier-Bohr ![]() sont toutes multiples des

sont toutes multiples des ![]() . L'ensemble

. L'ensemble

![]() est tel que

est tel que ![]() est fini et les

est fini et les ![]() sont incommensurables.

sont incommensurables.

La polypériodicité impose d'une part un nombre fini de fréquences fondamentales incommensurables et n'est plus définie à l'aide d'une convergence uniforme d'autre part. La fonction

![]() utilisée pour illustrer les fonctions presque périodiques sera donc polypériodique si

utilisée pour illustrer les fonctions presque périodiques sera donc polypériodique si ![]() est fini. Cette distinction permettra d'être plus proche de la réalité où les fréquences fondamentales sont générées par un nombre fini de procédés physiques.

est fini. Cette distinction permettra d'être plus proche de la réalité où les fréquences fondamentales sont générées par un nombre fini de procédés physiques.

Un processus stochastique

![]() réel est dit polycyclostationnaire (

réel est dit polycyclostationnaire (![]() ) avec les périodes cycliques

) avec les périodes cycliques ![]() si sa fonction de répartition est polypériodique selon ces mêmes périodes.

si sa fonction de répartition est polypériodique selon ces mêmes périodes.

Nous allons inclure également dans la polycyclostationnarité le cas où les ![]() sont rationnels entre eux (commensurables). Dès lors, il convient d'envisager 2 cas.

sont rationnels entre eux (commensurables). Dès lors, il convient d'envisager 2 cas.

Si les périodes cycliques

![]() sont toutes rationnelles entre elles, il est possible de trouver une période cyclique commune

sont toutes rationnelles entre elles, il est possible de trouver une période cyclique commune ![]() multiple de chacune des périodes cycliques

multiple de chacune des périodes cycliques ![]() . Dès lors, l'ensemble des

. Dès lors, l'ensemble des

![]() engendrera une fréquence commune

engendrera une fréquence commune ![]() .

.

Afin d'illustrer le calcul de la période commune nous allons nous baser sur un exemple concret : les engrenages. La figure ![]() présente le multiplicateur utilisé au LIS1.3 dans le cadre de l'Action Incitative Diagnostic et Signal1.4. Le multiplicateur présenté sur la figure

présente le multiplicateur utilisé au LIS1.3 dans le cadre de l'Action Incitative Diagnostic et Signal1.4. Le multiplicateur présenté sur la figure ![]() est constitué de roues ayant respectivement

est constitué de roues ayant respectivement ![]() et

et ![]() dents.

dents.

Les deux roues tournent à des vitesses différentes, elles vont générer des signaux périodiques de périodes ![]() et

et

![]() . A chaque tour de la roue menante, il y a 57 contacts entre les dents des deux roues (la roue menante engrène la roue menée). Néanmoins, les dents en contact ne sont pas les mêmes d'un tour à l'autre. De plus, la surface de chaque dent n'est pas rigoureusement identique et particulièrement si il y a un défaut. Dès lors, le phénomène d'engrènement va introduire une période commune

. A chaque tour de la roue menante, il y a 57 contacts entre les dents des deux roues (la roue menante engrène la roue menée). Néanmoins, les dents en contact ne sont pas les mêmes d'un tour à l'autre. De plus, la surface de chaque dent n'est pas rigoureusement identique et particulièrement si il y a un défaut. Dès lors, le phénomène d'engrènement va introduire une période commune ![]() . Le terme

. Le terme ![]() correspondra à l'angle nécessaire pour que l'engrenage revienne dans la même configuration (mêmes dents en contact).

correspondra à l'angle nécessaire pour que l'engrenage revienne dans la même configuration (mêmes dents en contact).

La période commune correspond à un nombre de dents égal au plus petit commun multiple (ppcm) de ![]() et

et ![]() . Soit :

. Soit :

La figure ![]() présente des signaux issus de ce réducteur. Les bandes alternativement noires et blanches indiquent respectivement, la période de rotation de l'arbre d'entrée

présente des signaux issus de ce réducteur. Les bandes alternativement noires et blanches indiquent respectivement, la période de rotation de l'arbre d'entrée ![]() , la période de rotation de l'arbre de sortie

, la période de rotation de l'arbre de sortie ![]() , et, la période commune

, et, la période commune ![]() . En regardant attentivement les bandes, on vérifiera que l'on a une synchronisation des bandes tous les

. En regardant attentivement les bandes, on vérifiera que l'on a une synchronisation des bandes tous les ![]() degrés. Dans notre cas, la période commune correspond à

degrés. Dans notre cas, la période commune correspond à ![]() tours de l'arbre d'entrée et à

tours de l'arbre d'entrée et à ![]() tours de l'arbre de sortie. En regardant la figure nous apercevons nettement la période correspondant à l'arbre d'entrée qui module fortement le signal. Cette forte modulation est due au très mauvais état du réducteur et plus particulièrement de la roue menante. La période commune est difficile à déceler sur cette figure.

tours de l'arbre de sortie. En regardant la figure nous apercevons nettement la période correspondant à l'arbre d'entrée qui module fortement le signal. Cette forte modulation est due au très mauvais état du réducteur et plus particulièrement de la roue menante. La période commune est difficile à déceler sur cette figure.

Afin de mettre en évidence cette périodicité, le signal accélérométrique a été découpé en tranches correspondant à un cycle commun. Les tranches étant ensuite affichées les unes en dessous des autres (figure ![]() ). La période commune est multiple des périodes de rotation de l'arbre d'entrée et de l'arbre de sortie. Il est donc possible de considérer uniquement cette période comme le suggère la figure

). La période commune est multiple des périodes de rotation de l'arbre d'entrée et de l'arbre de sortie. Il est donc possible de considérer uniquement cette période comme le suggère la figure ![]() . Dans ce cas, le signal devient cyclostationnaire, et, est beaucoup plus simple à étudier, néanmoins, on ne prend plus en compte la contribution de chacune des roues.

. Dans ce cas, le signal devient cyclostationnaire, et, est beaucoup plus simple à étudier, néanmoins, on ne prend plus en compte la contribution de chacune des roues.

Nous allons donner un exemple qui va fortement nuancer cette approche, les signaux proviennent d'un réducteur fabriqué par la société FOC-MANQUAT utilisé au LASPI1.5.

La figure ![]() montre une roue du réducteur (à gauche), le réducteur (au milieu) ainsi que son schéma cinématique (à droite). Soit

montre une roue du réducteur (à gauche), le réducteur (au milieu) ainsi que son schéma cinématique (à droite). Soit ![]() le nombre de dents correspondant à la

le nombre de dents correspondant à la

![]() roue, tel que

roue, tel que ![]() pour l'arbre d'entrée, et

pour l'arbre d'entrée, et ![]() le nombre de roues. Pour notre réducteur, nous avons

le nombre de roues. Pour notre réducteur, nous avons

![]() et

et ![]() .

.

Pour ce type d'engrenage à plusieurs étages, il y a de nombreuses périodes de rotation: on pourra généraliser les développements précédents à chaque couple ou ensemble de roues pour calculer des périodes communes locales. Pour les engrenages à plusieurs étages, l'angle à partir duquel l'engrenage revient dans la même configuration va dépendre de toute la cinématique (nombre de dents). En généralisant l'équation ![]() , on obtient une période commune

, on obtient une période commune ![]() :

:

|

(1.37) |

Afin d'illustrer cette formule, nous allons l'appliquer au réducteur du LASPI. Pour voir l'évolution de cette période en fonction du nombre d'étages du réducteur, nous allons la calculer pour les 2 premières roues, les 4 premières, ...

| Nombre de paires de roues prises en compte | 1 | 2 | 3 | 4 |

| Période commune (tours) | 62 | 868 | 51 212 | 3 123 932 |

| Durée (1500 trs/min) | 3 s | 35 s | 34 min | 1,5 jour |

Nous constatons alors que plus le nombre d'étages du réducteur devient grand, plus il est irréaliste de travailler sur certaines périodes communes très grandes. Pour réaliser des statistiques basées sur la période commune, il est nécessaire d'enregistrer un grand nombre de cycles. Une limite à ![]() cycles correspond à une durée d'acquisition de

cycles correspond à une durée d'acquisition de ![]() mois et

mois et ![]() semaines. Cette problématique nous amènera à définir plus loin la semicyclostationnarité et la pseudo-cyclostationnarité. Considérer qu'un signal d'engrenage polycyclostationnaire se réduit à un signal cyclostationnaire, ne fonctionne que pour des réducteurs ayant un faible nombre d'étages.

semaines. Cette problématique nous amènera à définir plus loin la semicyclostationnarité et la pseudo-cyclostationnarité. Considérer qu'un signal d'engrenage polycyclostationnaire se réduit à un signal cyclostationnaire, ne fonctionne que pour des réducteurs ayant un faible nombre d'étages.

En pratique, on se focalisera sur les périodes cycliques que l'on souhaite étudier. Les périodes cycliques plus longues seront tronquées lors de l'acquisition ``trop courte''. Elles n'apparaîtront donc plus en tant que périodes mais comme un signal pseudo aléatoire. Il est donc important de ne pas perdre de vue que les résultats seront biaisés (voir chapitre ![]() pour plus de détails).

pour plus de détails).

Ce type de polycyclostationnarité est appelé quasi-cyclostationnarité par Gardner [#!gardner:stationarizable!#].

La quasicyclostationnarité intervient par exemple, dans le signal où il y a présence d'une composante d'origine électrique et d'une composante d'origine mécanique. La figure ![]() présente au centre un signal acquis par un ensemble capteur/conditionneur de mauvaise qualité. Le capteur de type vibratoire était pollué par le secteur à

présente au centre un signal acquis par un ensemble capteur/conditionneur de mauvaise qualité. Le capteur de type vibratoire était pollué par le secteur à ![]() . Ce signal est donc quasicyclostationnaire. En se synchronisant sur la période cyclique mécanique, il a été possible, par moyennage synchrone de séparer la composante mécanique périodique de la composante électrique. Cet exemple montre que les signaux quasicyclostationnaires posent moins de problème que les signaux polycyclostationnaires pour l'estimation des différentes composantes, puisque les exponentielles de Fourier associées aux différentes fréquences fondamentales ainsi qu'à leurs harmoniques sont disjointes. Néanmoins, leur séparation devient délicate si les fréquences sont ``relativement proches'' (canaux non distincts sur une densité spectrale pour le pas d'échantillonnage utilisé).

. Ce signal est donc quasicyclostationnaire. En se synchronisant sur la période cyclique mécanique, il a été possible, par moyennage synchrone de séparer la composante mécanique périodique de la composante électrique. Cet exemple montre que les signaux quasicyclostationnaires posent moins de problème que les signaux polycyclostationnaires pour l'estimation des différentes composantes, puisque les exponentielles de Fourier associées aux différentes fréquences fondamentales ainsi qu'à leurs harmoniques sont disjointes. Néanmoins, leur séparation devient délicate si les fréquences sont ``relativement proches'' (canaux non distincts sur une densité spectrale pour le pas d'échantillonnage utilisé).

C'est aussi le cas des signaux de machines asynchrones qui tournent à une fréquence légérement inférieure à la fréquence du champ tournant (phénomène de glissement). Ce champ tournant est lui même lié à la fréquence d'alimentation par un coefficient correspondant au nombre de paires de pôles. Dès lors, les fréquences associées aux signaux électriques et mécaniques sont situées à des fréquences très proches et sont alors difficiles à distinger.

Le concept de cyclostationnarité est essentiellement théorique. Il est impossible de vérifier expérimentalement la cyclostationnarité en raison même de la durée finie de toute expérience. On propose alors d'adapter le concept de semistationnarité tel qu'il est présenté dans [#!picinbono:signaux2!#] aux signaux cyclostationnaires.

Soit :

|

(1.38) |

La définition de la semistationnarité peut être retrouvée en enlevant le préfixe cyclo et en supprimant ![]() au profit de la longueur de corrélation

au profit de la longueur de corrélation ![]() . La longueur de corrélation est le temps à partir duquel on considère que la fonction de corrélation est nulle. Dans le contexte cyclostationnaire

. La longueur de corrélation est le temps à partir duquel on considère que la fonction de corrélation est nulle. Dans le contexte cyclostationnaire ![]() ne peut être défini puisque la fonction d'autocorrélation est périodique, c'est pourquoi nous le remplaçons par

ne peut être défini puisque la fonction d'autocorrélation est périodique, c'est pourquoi nous le remplaçons par ![]() et par

et par ![]() . Ainsi, nous reprenons l'idée qu'il est nécessaire de connaître le signal sur une durée supérieure aux constantes de temps du système afin de pouvoir tirer des conclusions pertinentes. Dans le cas des signaux cyclostationnaires la fonction de corrélation n'est pas décroissante mais périodique, on pourra alors estimer la période suivante à partir de la période précédente.

. Ainsi, nous reprenons l'idée qu'il est nécessaire de connaître le signal sur une durée supérieure aux constantes de temps du système afin de pouvoir tirer des conclusions pertinentes. Dans le cas des signaux cyclostationnaires la fonction de corrélation n'est pas décroissante mais périodique, on pourra alors estimer la période suivante à partir de la période précédente.

En général, lorsque l'on traite des signaux issus de l'expérimentation, on parle par abus de langage de cyclostationnarité et d'estimation au lieu de semicyclostationnarité. Considérer un signal semicyclostationnaire signifie tout simplement que l'on a acquis suffisamment de points pour l'analyser.

L'hypothèse de semicyclostationnarité n'est pas toujours valide. Par exemple, si l'enregistrement est trop court pour observer l'ensemble des périodes cycliques, ou dans le cas de réducteurs à engrenage dont le rapport de réduction est important. Le processus bien que cyclostationnaire n'apparaît pas en tant que tel sur le signal.

Par ailleurs, un signal peut apparaître cyclostationnaire pour une observation, donnée alors qu'il est non stationnaire. Lors d'une observation certains paramètres apparaissent constants (niveau d'huile, état d'usure du système, ...). Après un certain temps (par exemple 500 000 km pour des roulements de roue d'automobile), on peut noter l'évolution de paramètres qui apparaissaient comme constants. D'autre part, certaines approximations ne seront plus valables (la fluctuation autour de la période moyenne sera de plus en plus importante dans un procédé de type marche aléatoire comme les roulements). On a donc ici une sorte de cyclostationnarité définie localement.

De tels signaux non semi-cyclostationnaires, seront appelés pseudo-cyclostationnaires.

Jusqu'à présent les définitions ont été données dans le domaine angulaire puisque la variable générique des machines tournantes est l'angle. Néanmoins, il est courant d'utiliser le temps pour échantillonner de tels signaux. Les signaux peuvent alors devenir non stationnaires et non cyclostationnaires à cause des fluctuations de vitesse. Il est néanmoins dommage dans ce cas de ne pas utiliser le fait que les signaux soient issus de machines cycliques. C'est pourquoi nous avons proposé de définir la cyclostationnarité floue afin de rétablir le lien avec la cyclostationnarité.

Nous désignerons sous le vocable ``cyclostationnaire floue'' les processus cycliques dont le ou les périodes cycliques sont variables qu'elles soient déterministes ou aléatoires.

Le chapitre ![]() sera consacré à l'étude de la cyclostationnarité floue.

sera consacré à l'étude de la cyclostationnarité floue.

Nous avons présenté dans ce chapitre les bases théoriques de la cyclostationnarité. La figure ![]() présente une synthèse des différents type de cyclostationnarité et leur lien avec la (non)-stationnarité sous forme de diagramme de Venn. La figure

présente une synthèse des différents type de cyclostationnarité et leur lien avec la (non)-stationnarité sous forme de diagramme de Venn. La figure ![]() montre un organigramme permettant de déterminer facilement le type de cyclostationnarité.

montre un organigramme permettant de déterminer facilement le type de cyclostationnarité.

Les chapitres suivant préciseront la notion de cyclostationnarité. Dans le chapitre ![]() nous allons présenter les différents types d'acquisitions (temporelle, angulaire), leurs avantages et inconvénients. Nous expliquerons également comment induire la cyclostationnarité pour les signaux temporels. Le chapitre

nous allons présenter les différents types d'acquisitions (temporelle, angulaire), leurs avantages et inconvénients. Nous expliquerons également comment induire la cyclostationnarité pour les signaux temporels. Le chapitre ![]() montrera les aspects plus pratiques de la cyclostationnarité et rapportera des exemples dans le cas des signaux d'engrenages.

montrera les aspects plus pratiques de la cyclostationnarité et rapportera des exemples dans le cas des signaux d'engrenages.

Ensuite nous ferons le lien entre la variable angulaire utilisée jusqu'à présent et la variable temporelle à l'aide de la cyclostationnarité floue. Cette dernière nous permettra également d'étudier les fluctuations de périodes cycliques. Le chapitre ![]() montrera comment exploiter des signaux de roulements produisant des signaux cyclostationnaires flous.

montrera comment exploiter des signaux de roulements produisant des signaux cyclostationnaires flous.